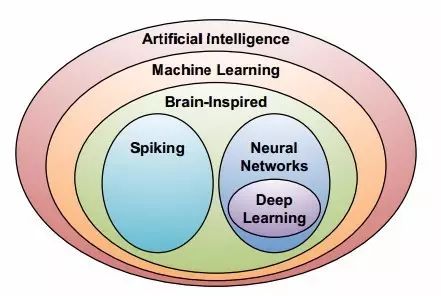

深度神經(jīng)網(wǎng)絡(luò)(DNN):準確性高但計算復(fù)雜,效率與吞吐量待提升

深度神經(jīng)網(wǎng)絡(luò)在語音識別與圖像識別領(lǐng)域?qū)崿F(xiàn)了重大突破,隨后相關(guān)應(yīng)用如雨后春筍般迅速增長。這一現(xiàn)象背后,隱藏著許多令人耳目一新的知識點,實為深入研究的寶貴素材。

DNN興起的背景

過去,專家們必須手動提取特征或制定規(guī)則,這樣的做法既費時又費力。但深度神經(jīng)網(wǎng)絡(luò)(DNN)的問世,徹底改變了這一狀況。它憑借在大量數(shù)據(jù)上運用統(tǒng)計學(xué)習(xí)技巧的能力,嶄露頭角。在眾多科研項目中,過去依賴人工分析樣本特征,效率十分低下。而DNN能夠自動從原始數(shù)據(jù)中提取高級特征,顯著提高了處理速度和準確性。這一轉(zhuǎn)變充分說明,技術(shù)革新往往源于對更高效率和效果的追求。各行各業(yè)都迫切需要這種高效的數(shù)據(jù)分析手段,DNN恰好滿足了這一需求。

DNN計算加速方法的研究

研究人員目前主要關(guān)注的是為DNN計算開發(fā)專門的加速技術(shù)。DNN在處理海量數(shù)據(jù)時,計算量十分龐大。特別是在醫(yī)療影像識別領(lǐng)域,每次處理數(shù)千甚至數(shù)萬個影像數(shù)據(jù),如果運算速度過慢,就會導(dǎo)致診斷結(jié)果延遲。因此,開發(fā)加速方法變得尤為迫切。眾多科技公司和研究機構(gòu)紛紛投入大量人力和財力進行相關(guān)研究。有些團隊致力于優(yōu)化算法邏輯,而另一些團隊則致力于硬件改進,努力尋找更適合DNN運算的硬件架構(gòu),以期提高運算速度,使DNN能更好地服務(wù)于各行各業(yè)。

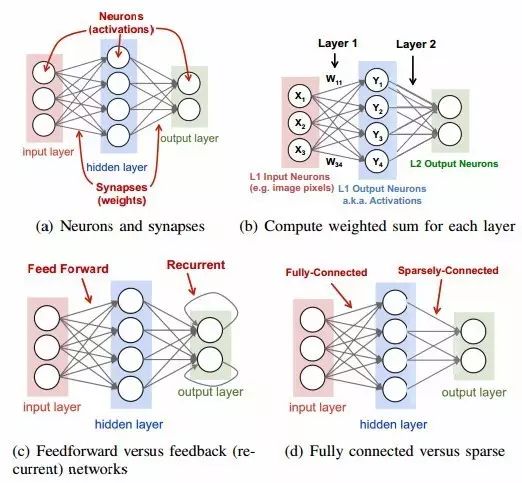

DNN的工作原理

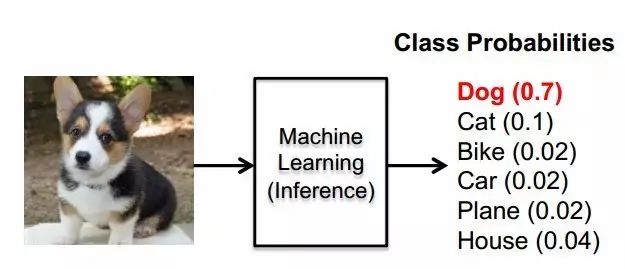

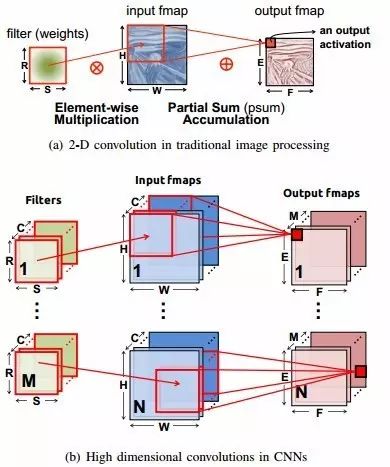

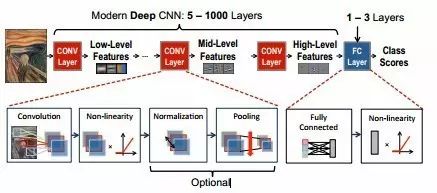

機器學(xué)習(xí)算法只需經(jīng)過訓(xùn)練,就能處理某一領(lǐng)域的新問題,而不需要特定的編程。神經(jīng)網(wǎng)絡(luò)的工作原理是,基于輸入值進行加權(quán),并應(yīng)用非線性函數(shù)。以圖像分類為例,圖像的像素數(shù)據(jù)首先輸入網(wǎng)絡(luò)的第一層,通過加權(quán)可以提取出低階特征。在訓(xùn)練過程中,網(wǎng)絡(luò)會根據(jù)這些低階特征,結(jié)合高階特征,給出對象的概率,也就是分類結(jié)果。這個過程就像一個智能的分揀機,不同的特征就像是不同的分揀標準,按照既定的邏輯,將對象分到不同的類別。在其他領(lǐng)域,如文本分類等,也遵循著類似的邏輯。

DNN的訓(xùn)練目標與反向傳播

訓(xùn)練深度神經(jīng)網(wǎng)絡(luò)的核心任務(wù)是確定一套合適的權(quán)重,以實現(xiàn)大規(guī)模數(shù)據(jù)集損失的最小化。在此過程中,梯度的計算通過反向傳播技術(shù)得以高效實現(xiàn)。以交通流量預(yù)測的DNN訓(xùn)練為例,需依據(jù)海量的歷史交通流量數(shù)據(jù)來尋找最優(yōu)權(quán)重。為了確保預(yù)測結(jié)果的偏差盡可能小(即損失最小),反向傳播算法持續(xù)調(diào)整權(quán)重。損失值的影響會反向傳遞,通過網(wǎng)絡(luò)評估來衡量權(quán)重對其的影響。這一過程不僅需要大量的計算資源,還需要豐富的數(shù)據(jù)樣本,同時對于權(quán)重的初始設(shè)置等也極為敏感。

無監(jiān)督學(xué)習(xí)與深度學(xué)習(xí)框架

無監(jiān)督學(xué)習(xí)是DNN中不可或缺的技術(shù),其訓(xùn)練樣本不帶有標簽,主要目的是尋找數(shù)據(jù)中的結(jié)構(gòu)或進行聚類。這種方法促進了眾多深度學(xué)習(xí)框架的進步,而且這些框架大多都是開源的。因此,眾多研究者和從業(yè)者能夠輕松地運用DNN網(wǎng)絡(luò)。在探索未知的數(shù)據(jù)分析領(lǐng)域,無監(jiān)督學(xué)習(xí)展現(xiàn)出強大的能力,比如在尋找宇宙信號的來源上,由于許多信號都是未知的、無標簽的,無監(jiān)督學(xué)習(xí)便能夠挖掘出潛在的結(jié)構(gòu)。此外,開源框架的普及降低了使用門檻,使得更多的人能夠參與到DNN的研究和應(yīng)用開發(fā)中。

DNN的性能優(yōu)化與發(fā)展

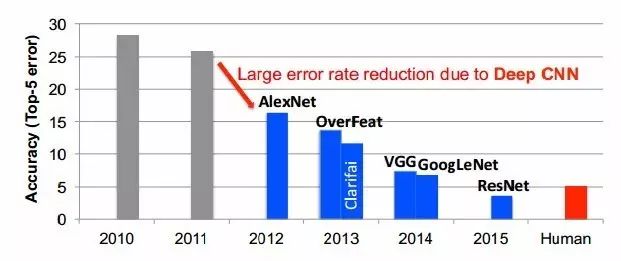

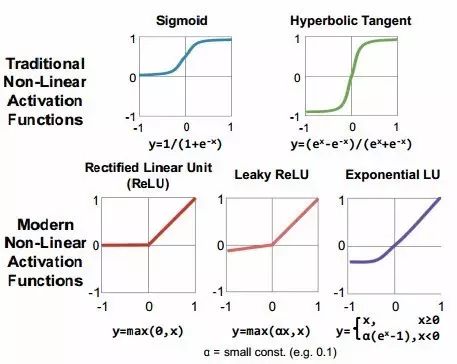

DNN的發(fā)展歷程中,涌現(xiàn)出眾多優(yōu)化策略。例如,ReLU及其變體函數(shù)已被證實能提高模型準確性,因此越來越受到青睞。此外,通過將某些激活函數(shù)之間的連接權(quán)重設(shè)為零,可以減少參數(shù)數(shù)量,同時不影響準確性。在嵌入式平臺應(yīng)用中,面臨著嚴格的能耗、計算和存儲成本限制。2012年,多倫多大學(xué)的研究團隊利用圖GPU技術(shù),將錯誤率降低了約10%。而且,不同網(wǎng)絡(luò)結(jié)構(gòu)之間可以相互借鑒優(yōu)化經(jīng)驗。例如,若某網(wǎng)絡(luò)與另一結(jié)構(gòu)相似,適當(dāng)調(diào)整濾波器數(shù)量,就可能提升準確度。這些因素共同推動了DNN向更優(yōu)方向發(fā)展。

閱讀了這些關(guān)于深度神經(jīng)網(wǎng)絡(luò)(DNN)的資料后,我們是否思考過,DNN將來會如何深刻影響我們的日常生活?期待大家積極點贊,轉(zhuǎn)發(fā)這篇文章,并在評論區(qū)留下你的見解。

作者:小藍

鏈接:http://www.beijingshangmencuiru.cn/content/4954.html

本站部分內(nèi)容和圖片來源網(wǎng)絡(luò),不代表本站觀點,如有侵權(quán),可聯(lián)系我方刪除。